北大-灵初发布具身VLA全面综述! 一文看清VLA技术路线与未来趋势

北大-灵初发布具身VLA全面综述! 一文看清VLA技术路线与未来趋势

更新时间: 浏览次数: 258

机器之心发布

机器之心编辑部

如今,GPT-4o、Gemini 2.5 Pro 等多模态基础模型在对话、代码生成和数学推理等任务中已经达到甚至超越了人类水平。研究者开始探索如何将这种智能从数字世界延伸至物理空间,以实现具身智能。这其中最受关注的前沿方向之一,便是视觉 - 语言 - 动作模型(Vision-Language-Action Models,简称 VLA)。此类模型借助基础模型的通用能力与大规模学习范式,可以处理通用的视觉(Vision)与语言(Language)输入,并生成实时动作(Action),极大地赋能了机器人系统。

近两年来,VLA 相关研究爆发式增长,技术路线日新月异 —— 但这也造成了认知碎片化与理解上的困难。现有分类方法如 “大脑 - 小脑”、“快慢系统”、“分层 - 端到端” 等,直觉清晰但本质仍不明确。领域急需系统化的分析框架,以梳理研究现状,指明未来方向。

为此,北京大学 - 灵初智能联合实验室首次从动作词元化(action tokenization)视角,提出统一理解 VLA 模型的新框架。综述系统分析了八种主流 action token,探讨了不同动作表示背后的能力支撑、数据扩展策略和适用场景,明确了未来的架构趋势与关键挑战。论文由灵初智能 00 后联合创始人陈源培与北京大学人工智能研究院助理教授杨耀东共同担任通讯作者。

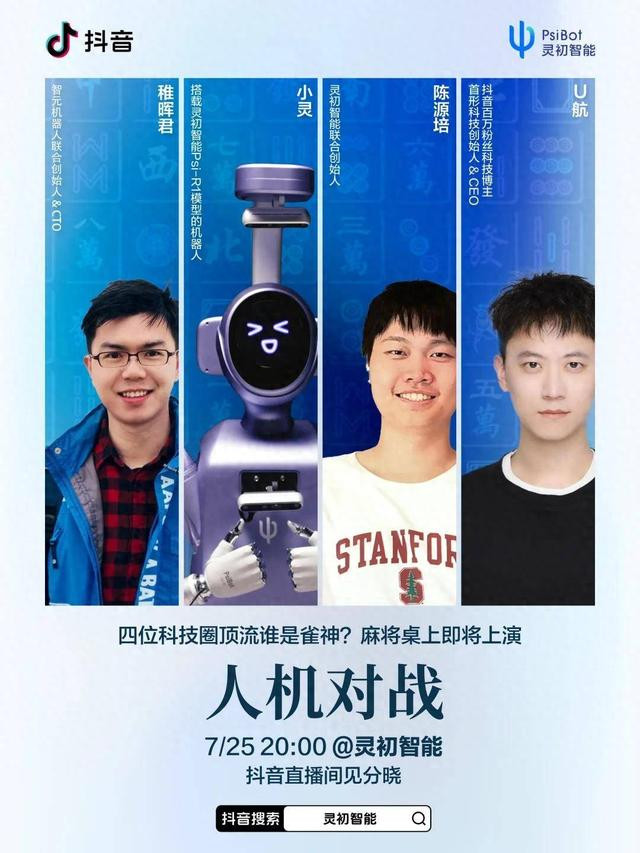

值得一提的是,在发布这一重要理论成果的同时,灵初智能也在加速推进 VLA 技术的产业化落地。其自研的 VLA 模型 Psi R1 已在麻将机器人等实际场景中得到验证,7/25 晚 20:00 锁定抖音直播,灵初智能联合创始人陈源培将与搭载 Psi R1 的灵初智能机器人小灵、智元机器人联合创始人稚晖君和首形科技创始人 U 航展开一场麻将对战。

除此之外,还有外卖机器人、超市打包机器人等也将在 WAIC 2025(7 月 26-29 日,上海世博展览馆 H3-C604 展位)上进行集中展示,为业界提供从理论到应用的完整技术路径参考。

论文标题:A Survey on Vision-Language-Action Models: An Action Tokenization Perspective

论文链接:https://arxiv.org/abs/2507.01925

仓库地址:https://github.com/Psi-Robot/Awesome-VLA-Papers

核心观点总结

VLA 统一框架与 Action Token 分类:当前的 VLA 系统遵循一个通用框架:视觉与语言输入经过一系列 VLA modules 逐级处理,生成逐渐具体的 action token,最终转化为动作输出。在该框架中,action token 可分为 language description、code、affordance、trajectory、goal state、latent representation、raw action 和 reasoning 八类。VLA 中的 action token 是 LLM 中 language token 的推广。

Action Token 发展趋势:VLA 模型的未来不在于依赖单一 action token,而在于多种 token 的协同。Language motion 表达能力有限,难以成为主流; language plan 在任务分解中不可或缺。Code 是另一种高效的规划形式,其潜力依赖于构建完备的感知与动作函数库。Affordance(做什么)与 trajectory(如何做)可互补结合,并借助 goal state 的目标预测提升生成精度。Latent representation 虽具潜力,但训练中面临粒度、语义覆盖和任务对齐等挑战。Raw action 最适合端到端学习,但能力高度依赖数据。Reasoning 可作为 “元 token” 增强其他 token 的生成,未来将从基于 language token 的推理发展为基于 action token 的多模态推理,并支持任务适应性推理计算。

新兴 Action Token 类型:Action token 类型由基础模型的能力决定。随着模型的演进和听觉、触觉等新模态的引入,未来可能涌现出更多新的 action token 类型与子类型。

VLA 架构趋势:未来的 VLA 模型很可能采用分层架构:顶层通过 language description 和 code 实现长程规划与逻辑控制。下层在近期内预计将使用 goal state 的视频预测、trajectory 的流建模以及 affordance 的三维交互预测紧密结合,形成中间动作表示,最终映射为 raw action。长期来看,下层将演化为完全端到端的方式,直接从子任务级输入预测 raw action。reasoning 按需贯穿整个 VLA 模型,增强 action token 生成。

从模仿学习到强化学习:引入强化学习可帮助 VLA 模型突破模仿学习的局限,实现类人试错与自主探索。实际部署则需更高效的强化算法,以应对高重置成本和低交互效率。同时,VLM 可自动生成密集奖励,加速训练与应用。

从 VLA 模型到 VLA 智能体:VLA 模型应向具备记忆、探索、规划和反思能力的主动型 VLA 智能体演进,并由线性结构转向更复杂的双向或图结构架构。

模型、数据与硬件协同发展:具身智能旨在应对物理世界的非结构化与开放性挑战,亟需模型、数据与硬件协同发展。然而受限于机器人平台与高质量数据匮乏,研究多局限于简化实验场景,整体仍处早期阶段。实现通用智能需三者协同演进,协力前行。

安全与对齐:当前的 VLA 研究主要关注模型能力,未来必须更加重视安全性与人类对齐。

VLA 统一框架与 Action Token 视角

VLA 模型指依托至少一个视觉或语言基础模型,能够根据视觉与语言输入,生成动作输出的模型。其本质目标是将基础模型在数字世界中的智能延伸到物理世界,实现具体的、具身的任务执行能力。

VLA 统一框架描述了不同 VLA 模型共同遵循的通用架构:即视觉和语言输入经过一系列功能模块(VLA modules),逐层处理并生成更具体、可执行的动作信息(action token),最终转化为实际的动作输出。

VLA module 指 VLA 模型中支持端到端梯度传播的最大可微子网络,或不可微的功能模块(如 motion planning),承担特定的能力(例如场景感知、动作规划等),并在模型内部彼此协同工作。

Action token 则是不同 VLA modules 之间传递的动作表示,承载具体动作信息。可以理解为 VLA 模型生成的 “动作语言”,用于明确不同模块间的沟通内容与执行目标。

举个具体的例子,以完成 “端茶倒水” 任务为例:

首先,一个 VLA module 处理视觉输入和语言指令,接受指令 “我渴了,请为我倒一杯茶”,识别场景中的茶壶、茶杯等物品,并规划出下一步的子任务目标,比如:“抓起茶壶把手”。这里生成的子任务描述即为一种 action token(此处为 language plan)。

接着,另一个 VLA module 接收该 action token,进一步规划具体的抓取路径与运动轨迹,并生成更加具体的动作描述(例如 trajectory)。

最终,这些更具体的 action tokens 被下游的模块转化为机器人可以直接执行的动作序列(即 raw actions),实现 “端茶倒水” 的实际行为。

这样的模块化结构和 action token 的概念,不仅明确了 VLA 系统的内部结构,也为深入分析和理解该类模型提供了统一的视角和框架。基于此,这篇综述发现当前的 VLA 模型主要使用了八种 action token,并进行了系统的分类梳理与分析。

综述论文还以时间轴的形式展示了基础模型、基于 action token 分类的 VLA 模型,以及相关数据工作的演进历程。其中呈现出的 U 形结构清晰地表明,VLA 模型的快速发展受到基础模型与数据资源持续进步的双重驱动。

八种 Action Token 的梳理分析

Language Description(语言描述)

用自然语言的形式描述要完成的动作,按照描述颗粒度主要分为子任务级别的 language plan(“端起茶杯”)和原子动作级别的 language motion(“手往前伸”)两种。

该类方法利用 LLM 和 VLM 在理解、推理、分解任务等方面的能力,使机器人能够以更 “类人” 的方式规划和执行复杂任务。

早期工作如 Language Planner、SayCan 等表明,LLM 可直接将高层指令拆解为语义明确的子任务(language plan),大幅降低人工设定需求。为了缓解仅使用 LLM 导致的缺乏环境感知的缺陷,他们引入视觉模块和动态反馈等显式的落地机制,提升了模型对实际场景的适应和操作能力。后续研究直接使用 VLM 进一步提升多模态理解和规划能力。此外,针对复杂和长时任务,部分研究(如 BUMBLE、ReflectVLM)引入了记忆与反思机制,使系统具备分阶段推理与跨场景适应能力。最近的 Hi Robot、pi0.5 等则进一步消除了下层简单策略的能力限制,扩展到能执行通用 language plan 的策略,实现了更强的任务泛化和动态修正能力。在细粒度 language description 的研究方面,RT-H、NaVILA 等工作将低层动作细化为 language motion,促进了跨任务的数据共享和人机交互。

这一范式展示出诸多优势。一是与基础模型高度兼容:语言描述与 LLM/VLM 的原生输出空间一致,能够充分发挥模型的理解、推理和规划能力,实现零样本(zero-shot)或少样本(few-shot)泛化,显著降低任务定制化成本。二是丰富的训练数据支持:借助海量图文与操作数据,语言描述能有效迁移现实世界知识,提升模型的泛化性与可扩展性。三是更强的长时规划能力:分层的语言指令有助于模型处理长链路、多阶段任务,支持复杂任务的结构化分解和执行。四是高度可解释性与可控性:自然语言表达易于人类理解和干预,方便实现人机协同、动态纠错与在线优化。

但当前也面临表达精度不足与推理时延等挑战。未来,研究趋势是将 language description 用于高层规划,底层控制则结合 affordance、trajectory、goal state 等精细表示,从而兼顾任务复杂性和动作精确性,推动具身智能系统在复杂环境下的实用落地。

Code(代码)

用代码的形式表达任务的实现逻辑,包含循环、分支等逻辑控制和机器人感知、控制的 API 调用。

代码是人类与计算机之间最直接也最高效的交流方式。文章系统梳理了近年来以 code 为 action token 的 VLA 研究进展,聚焦其如何从 “能运行的控制代码” 演进为 “具备逻辑结构、感知能力与任务泛化能力的机器人行为策略”。代码其核心思想是:将自然语言和视觉输入转化为结构清晰、具备可读性与可执行性的程序或伪代码,摆脱对神经网络隐式向量的依赖,用明确、透明的代码来驱动机器人行为。

code 的主要优势在于当前语言模型在代码生成方面已展现出极强的能力。生成的程序不仅能够自然地调用预定义的机器人操作 API,也可以集成感知基础模型提供的识别模块,还能灵活接入如 NumPy、PyTorch 等常用库进行空间计算与逻辑控制。这种模块化、可组合的特性,使得策略能够快速适配新任务,具备良好的扩展性与可调试性。同时,代码语言天然具备流程控制结构,如条件判断与循环语句,从而完成逻辑更复杂的任务规划。

但与此同时,code 也面临现实挑战。首先,它对 API 库的依赖极高,而 API 本身的覆盖范围往往受限。一旦机器人需要的功能未被定义,或已有接口无法适配当前任务需求,策略即失效。例如,如果现有控制 API 并不支持对 “湿滑地面”“易碎物体” 等复杂环境属性进行建模和调用,那么即使生成的代码逻辑正确,也无法稳健执行所需动作。其次,代码结构的固定性也带来了执行层的脆弱性。一方面,语言模型在生成代码时可能出现逻辑错误、结构冗余等问题,影响控制效率;但更严重的是,代码本身往往默认了若干环境前提条件。一旦实际场景违背这些假设(例如物体潮湿、位置偏移或不可见),系统可能触发不当操作,甚至导致物体损坏或设备安全风险。

因此,未来研究可以从两个维度进一步释放代码式策略的潜力。一方面,需要构建更完善、更语义丰富的机器人 API 库,使语言模型能够通过调用接口实现复杂任务的自动编排,尤其适用于多步骤、长时序的任务控制。另一方面,引入形式化验证机制以检测 API 调用的一致性与合法性,并配合运行时安全监控手段,降低执行层风险。同时,代码的可读性也为 “人机协同控制” 提供了天然接口 —— 人类可以参与策略微调、纠错甚至插入控制逻辑,为构建可信、可控的具身智能系统提供新的技术路径。

Affordance(可操作性)

一种基于空间的表示方式,刻画物体在当前任务中可以如何被交互使用。常见形式包括关键点(keypoint)、边界框(bounding box)、分割掩码(segmentation mask)或可操作图(affordance map)。

在具身智能系统中,如何将感知结果转化为可执行动作,始终是 “语言 - 感知 - 控制” 链条中最具挑战性的环节之一。近年来 VLA 兴起的一个关键方向是将 affordance(可操作性)作为结构化的 action token,用于连接高层感知理解与底层控制执行。所谓 affordance,指的是物体或区域 “可以被如何交互” 的结构化表示,例如杯沿可能是 “可抓取的”,抽屉把手可能是 “可拉动的”。相较于传统的坐标点或动作轨迹表示,affordance 更强调语义明确、空间对齐,并具备良好的任务适应性。当前的 VLA 研究中,affordance 动作表达的形式包括:关键点、边界框、分割掩码以及可操作性图,每种方式在任务类型、精度要求与环境复杂度之间展现出互补优势。

不同的表示形式各有侧重:关键点能够精确指示交互目标,如把手或按钮;边界框在多类检测模型和语言视觉模型支持下可高效实现实例定位;分割掩码为功能性区域提供像素级轮廓与几何细节,适用于复杂表面操作;而可操作性图则从全局视角提供稠密、概率化的交互区域分布,适合复杂场景下的空间推理与动作规划。

尽管具有结构清晰、跨平台迁移性强等优势,现有 affordance 动作表示仍面临三类核心挑战:一是空间表达维度不足,多数方法仍停留在 2D 或投影 3D 表达,难以胜任需要完整空间理解的真实操作任务;二是动态建模缺失,affordance 通常被视为静态属性,忽略了动作执行后的状态变化,无法处理例如 “打开瓶盖后变为可倒出” 的动态演化;三是感知鲁棒性有限,在遮挡、模糊等视觉干扰下容易出现误判,影响下游控制稳定性。

针对这些问题,文章总结出 affordance 动作表示未来的三个关键发展方向:

构建原生三维表达形式,基于神经辐射场、高斯渲染等方法,实现对物体几何与空间布局的真实建模;

引入时序建模机制,使模型能够感知并预测交互过程中的 affordance 演化,提高对长时序任务的适应能力;

增强策略鲁棒性与不确定性感知能力,不仅预测交互区域,还需识别模型自身置信度,提升决策安全性与可控性。

Trajectory(轨迹)

表示物体、末端执行器或场景随时间变化的连续空间状态序列,也就是 “从哪里到哪里怎么动”。

在 VLA 模型的研究中,一个核心挑战是附带动作标签的机器人数据集的稀缺性。近期研究表明,将 “轨迹(Trajectory)” 作为一种动作表征,是应对此挑战的有效范式。该方法通过利用无需动作标注的通用视频数据,用其中蕴含的运动轨迹来表示动作,从而显著拓宽了模型的训练数据来源。

该研究方向的核心在于将机器人动作编码为运动轨迹。这些表征主要分为三类:一是点轨迹(Point Trajectory),通过一系列时序下的离散坐标点来为机器人提供精确的路径引导;二是视觉轨迹(Visual Trajectory),它将运动路径直接渲染于图像之上,在视觉上下文中直观地呈现动作意图;三是光流(Optical Flow),作为一种更为稠密的表征,它描述场景中每个像素的运动矢量,从而捕捉了整体环境的动态信息。

基于轨迹的动作表征展现出多项关键优势。首先,正如前文所言,用轨迹作为动作表征可以有效地利用大量视频数据,拓宽训练数据来源。其次,也是至关重要的一点,轨迹在任务泛化上表现出卓越的能力。对于那些语义目标不同但底层运动模式相似的任务(例如 “擦拭表面” 与 “滑动滑块”),基于轨迹的策略能够实现更高效的零样本泛化。再次,与依赖隐空间表征的抽象方法相比,轨迹是一种外显且具备人类可解释性的动作形式,为模型的训练与调试提供了极大便利。

尽管前景广阔,该方法仍面临若干挑战。当前多数工作聚焦于二维轨迹,其固有的三维空间信息(尤其是物体姿态与旋转)的缺失,限制了其在复杂灵巧操作任务中的应用。同时,部分依赖大型生成模型的方法存在计算成本高、推理频率低的问题,难以满足机器人实时、平滑控制的需求。此外,纯轨迹表征在处理需要复杂交互逻辑、力控制或基于物体功能理解(affordance)的任务时,其语义丰富度尚显不足。

因此,未来的研究方向将主要聚焦于三个方面:一是探索包含完整六自由度(6-DoF)信息的三维空间轨迹表征;二是开发轻量化、高效率的轨迹生成与规划模型;三是构建结合了轨迹路径与语义概念的混合式动作表征,从而使机器人能够应对更广泛、更复杂的任务场景。

Goal State(目标状态)

对未来动作结果的视觉预测,如一张图片、点云或视频片段,直观地展示执行完某个动作序列后应该达到的目标样子,用作规划和执行的中间目标。

让机器人 “想清楚” 再行动。我们人类在执行任务前,常会先在脑中构想最终结果。受此启发,VLA 模型也开始采用预测的目标状态,即任务预期结果的视觉呈现,来作为中间的 “行动指令”。这就像在给机器人下达指令后,先让它 “想象” 出任务完成的样子,再根据这个 “想象” 来规划具体动作,从而弥合高层指令与低层执行之间的鸿沟。

这种方法通常采用分层架构:一个高层模型根据指令生成目标状态的图像或视频,随后低层模型依据这个视觉指引来生成最终的动作序列。目标状态主要分为单帧图像和多帧视频。单帧图像描绘任务完成后的静态场景,带来数据可扩展性高、能利用无动作视频训练等优势。而多帧视频则提供了更丰富的时间上下文和 “如何做” 的线索,能从大规模数据中生成、提取隐式动作信息,并增强模型在不同任务和机器人平台间的泛化能力。

目标状态的核心优势在于其极佳的数据可扩展性(通过自动化数据生成)、更广泛的数据源和更强的泛化能力(利用无动作视频和人类执行数据),以及增强的任务特异性(提供精确视觉指引),同时还具备鲁棒的可解释性和直观的评估方式。然而,目标状态也面临挑战:生成高质量、一致性的目标状态依然困难,可能出现过度具体或不准确的情况;此外,生成未来图像或视频会引入较高的推理延迟,影响实时控制。尽管如此,随着图像和视频生成技术的飞速发展,目标状态作为 VLA 模型中一个充满前景的行动指令,正不断提升机器人理解和执行复杂任务的能力。未来的研究将重点关注提高计算效率、增强环境鲁棒性,以及优化长程任务规划。

Latent Representation(隐式表示)

通过大规模数据预训练得到的一段隐向量序列,用来编码一定时间范围内与动作相关的信息。

如何让机器人像人一样,通过观察就能快速学习各种任务?近期的 VLA 研究开发了一种新的训练范式,不再大量依赖昂贵的、为机器人量身定制的训练数据,通过让 AI 模型观看多样的机器人视频数据集和海量的人类视频数据集(如 Ego4D 等),可以自动学习并提炼出一套通用的动作 “隐式表示(latent representation)”。

这一类方法的核心在于构建动作的隐式表示,根据编码的动作信息不同,主要分为以下三类:视觉变化信息,通过分析一段时间内视觉场景的变化(比如机械臂的移动),来推断其中发生的动作;动作块压缩信息,将一段完整的机器人动作序列(Action Chunk),直接压缩成一个高效、紧凑的 “动作 ID”;任务目标信息,将一系列的视觉观察,编码成一个具有高级语义的 “目标” 信息,指导后续行为。

这一 “潜在动作” 方法的价值是多方面的。首先,它极大地拓宽了数据来源,使得几乎所有机器人数据集和海量人类视频都能成为机器人的 “教科书”。其次,它显著提升了训练效率。例如,文中提到的 UniVLA 模型,采用该方法后,仅用 OpenVLA 所需 4.45% 的预训练时间,就达到了相当的性能,效率飞跃超过 20 倍。最关键的是,这种方法学习到的动作是 “身体无关” 的,意味着从人类视频中学到的操作技能,可以被有效迁移到拥有不同形态的机器人身上,展现了惊人的泛化能力。此外,潜在动作表示还有融合其他模态动作信息的潜力,比如触觉和听觉信息。

尽管有上述的种种优点,该方法也面临着挑战,主要在于其 “黑箱” 特性 —— 由于 “潜在动作” 由 AI 自主定义,其内部逻辑难以被人类完全理解和干预,这给调试和确保安全性带来了新的挑战。因此,确保这些潜在的动作表示具有良好的性质和质量变得尤为重要。未来的研究将聚焦于三大方向:如何让这套 “潜在动作” 的粒度更精细以支持复杂操作;如何确保其完备性以覆盖所有可能的任务场景;以及如何加强其与人类意图的对齐,确保机器人真正 “听得懂、干得对”。

Raw Action(原始动作)

可以被机器人直接执行的低层级控制指令,比如关节角度变化、末端位姿控制、轮子转速等。

近年来,大语言模型(LLM)所展现出的强大能力引发了广泛关注。正如 Richard Sutton 在《The Bitter Lesson》中所指出的,通向通用智能的长期路径并非依赖人类设计的领域知识,而是通过通用方法和扩展计算规模实现。LLM 的成功正源于其在预训练数据量和模型参数规模上的扩展(scaling law)。因此,一个自然而然的设想是:是否可以将 LLM 的成功经验推广到 VLA 模型中?

在所有的动作 token 表征方式中,raw action 是最直接的形式,它对应具身智能体的底层动作空间,例如机械臂的关节角度。这种表征天然具备无损性,既可直接从真实系统中采集,也可用于生成,省去了额外的动作格式映射步骤,因而非常适合 VLA 模型的端到端训练。随着数据规模和模型参数的不断增长,我们有理由期待 VLA 模型出现类似 LLM 的 scaling law,从而实现更强的泛化能力。

近年围绕 raw action token 的 VLA 模型的发展已初步展现出这一趋势。在数据层面,多个大规模机器人数据集陆续发布,如 RT 系列、Open-X Embodiment、DROID、AgiBot World,涵盖了跨本体、多任务的多样性数据。模型层面的发展也呈现出清晰的演进路径:从早期的简单多模态融合架构,发展到基于 Transformer 的自回归模型,再到近期基于基座 VLM 和扩散模型的动作块生成方法(Diffusion-based Action Chunking)。这些模型在参数规模和数据使用上不断扩展,并借助预训练的 VLM 提升了泛化能力,同时扩散模型结合动作块也显著增强了对精细动作分布的建模能力与动作生成频率。此外,LLM 中 “预训练 + 后训练” 的范式也在 VLA 中得到验证。研究表明,经过大规模数据预训练的 VLA 模型,在后训练阶段仅需少量新数据即可迁移至下游任务,大幅降低了微调与部署成本。

总体而言,基于 raw action 的 VLA 模型具有多方面优势:其表征无需人为设计或映射,最符合《The Bitter Lesson》中倡导的最少人类知识介入原则;其端到端可扩展结构便于借鉴 LLM/VLM 的成功范式;其预训练能力降低了后训练数据需求,使得在现实环境中的泛化部署成为可能。

然而,这一方向也面临若干挑战。首先,真实数据的获取成本高昂,当前最大规模的机器人数据集仍处于百万级别,远低于 LLM 所依赖的十亿级互联网语料,实现类似 scaling law 效应尚显不足。其次,大模型 VLA 的推理速度仍然受限,难以满足高实时性要求的精细操作任务。最后,实现单一模型的跨本体泛化能力仍是一个未解难题。未来的研究应聚焦于如何更高效地获取高质量数据、提升推理效率,并突破模型在异构机器人间的迁移能力等核心问题。

Reasoning(推理)

用自然语言表达的思考过程,解释 “为什么要做这个动作”,常用来辅助生成更合理的其他 action token。

机器人操作和自动驾驶等复杂的具身任务不仅需要长期规划和推理能力,更要求 AI 对空间、语义有深刻理解,并能在不断变化的真实世界环境中高效运行。仅仅依靠扩大模型参数规模,远不足以应对这些固有的复杂性。因此,为 VLA 模型注入强大的推理能力,已成为当前最迫切且有前景的解决方案。

我们所说的 VLA 中的推理,并非抽象概念,而是一个明确外化的、以自然语言形式呈现的深思熟虑过程。它扮演着关键的中间角色:当模型接收到高层指令时,推理步骤会引导其生成最终的目标 action token。这就像让人工智能拥有了 “思考” 的能力,能够一步步地权衡、判断,并将内部决策过程清晰地展现出来。

这种 “思考” 能力最初源于大型语言模型的 “思维链” 概念,即通过一系列中间步骤来解决复杂问题。如今,这一理念已成功拓展到 VLA 领域。早期,研究者常通过结合大型语言模型与额外视觉模块来实现具身推理。但现在,具备多模态先验知识的 VLM 已成为主流。VLM 能够简化模型架构,并通过专门的微调或再训练来适应具身推理的独特需求。一些方法通过自动化数据合成有效解决了高质量大规模推理数据集的获取难题,甚至将人类日常视频也纳入数据合成,拓宽了训练数据的来源。此外,一些 VLM 更是通过强化学习等方式,专门针对具身推理进行了深度优化。在自动驾驶这一高风险、高复杂度的应用场景中,这类模型将 “思维链” 应用于其场景描述、分析和规划等关键模块,充分展现了推理在处理复杂决策中的核心作用。

将推理融入 VLA 模型,带来了多重显著优势。它能有效弥合高层指令与底层行动的鸿沟,通过中间思考步骤提升模型对复杂指令的理解和分解能力,从而增强其在面对新场景和对象时的泛化性和对复杂任务的解决能力。此外,推理过程的外化极大地提高了模型的可解释性,使人类能清晰审查决策、定位错误并实时干预,从而深化人机协作。

然而,推理的应用也面临局限。最突出的是,推理过程往往涉及冗长序列,导致推理时间增加和执行速度降低,这对于需要实时响应的高频任务而言是关键瓶颈。同时,当前推理步骤的固定性以及高质量、大规模推理数据集构建的挑战,也限制了其灵活性和进一步发展。

VLA 中的数据来源

在 VLA 迅速发展的当下,“数据” 正成为决定模型能力边界的关键因素。因此,文章系统梳理了当前 VLA 模型所依赖的数据资源,并按照 “数据金字塔” 的框架,将其划分为三层:网络数据与人类视频、合成与仿真数据、真实机器人数据。这三类数据在模态组合、监督粒度和具身相关性上各具优劣,同时在性能与泛化能力之间形成了清晰的分工。

金字塔的底层由网络数据与人类视频构成。这类数据规模最大、获取成本最低,尽管不包含机器人可执行的动作标签,但它们为模型建立通用视觉语言理解能力提供了基础。例如,大量图文对支持模型学习物体、动作与场景的语义表征;而第一人称视角的人类演示视频(如厨房任务)则提供了丰富的多模态信息。虽然这些数据缺乏动作监督与精确标注,但其强语义密度使其成为 VLA 预训练中不可或缺的资源,帮助模型 “看懂世界”“听懂任务”,为后续具身接入与行为学习打下语义基础。此外,这类数据还广泛用于训练 trajectory,latent representation 等 action token。

金字塔的中层由合成与仿真数据构成。相比昂贵而稀缺的真实机器人数据,这类数据提供了高性价比且更多样化的数据;相比人类视频,它包含明确的动作标签。主流做法包括两类:离线数据合成与交互式仿真平台。离线数据合成方法如 MimicGen、DexMimicGen 和 RoboCasa,通过程序化修改、动力学扰动等手段,从少量演示中生成覆盖广泛任务与环境变化的大规模轨迹数据。而交互式仿真平台(如 Isaac Lab、Habitat、robosuite 等)则提供了一个可反复试验、高度可控的 “具身训练场”。研究者可以通过遥操作、算法规划或强化学习等方式持续生成行为数据,并通过程序生成器不断多样化环境配置。值得注意的是,越来越多的仿真平台开始融合高保真物理引擎与真实 3D 场景资产,使仿真交互更接近现实,适用于复杂任务的预训练。

金字塔的顶层是真实机器人数据,承载了物理世界中最具真实性的动作信息。相比仿真或人类演示,真机数据包含了现实世界中的动态变化、感知噪声与物理约束,是将策略 “从仿真走向真实” 的关键支撑。综述系统梳理了多个代表性数据集:多机器人数据(如 OXE、RoboMIND),单机器人数据集(如 RT-1、DROID、AgiBot World),以及自动驾驶任务中的时序轨迹(如 Waymo Open Dataset-Motion)。这些数据覆盖了各种场景中不同形态的机器人完成不同任务的真机轨迹,还在故障轨迹、力矩 / 声音模态等方面提供了学习样本,为策略训练带来了更强的现实鲁棒性与泛化数据支撑。

结语

VLA 模型正迅速成为通往具身智能的核心路径。这篇综述首次从 action token 视角系统梳理 VLA 技术路线,明确八类 token 的设计思路、优劣权衡与发展趋势,并指出当前研究中的关键挑战与未来方向。随着基础模型能力的持续跃升、数据的不断扩展、研究人员的不断努力,VLA 研究正在迈向通用智能的下一站。

在即将到来的 2025 世界人工智能大会(7 月 26-29 日)上,灵初智能将全面展示 VLA 技术的产业化成果,其发布的 Psi R1 模型能够实现 30 分钟连续麻将博弈,展现了机器人在开放环境下处理复杂任务的突破性能力,标志着具身智能从简单动作执行向真正的认知决策和长程操作的关键跃迁。这将为业界提供一个观察 VLA 技术从理论突破走向实际应用的重要窗口,共同推动具身智能技术在真实世界中的广泛落地。

机器人概念异动拉升 春兴精工6天3板每经AI快讯,9月9日,早盘机器人概念异动拉升,春兴精工6天3板,万马股份封涨停,泰禾智能、沃特股份、恒帅股份、豪恩汽电等跟涨。海量资讯、精准解读,尽在新浪财经APP

推荐阅读

奇瑞汽车被指强制加班“卷”时长

746

746

央媒评多地挪用农村学生营养餐补贴

217

217

花间一梦

2025-09-10 12:27:11

553

553

553

553

多个美军基地进入高度戒备

455

455

法国队主帅:乌龙球也是进球

26

26

2024上半年电影总结 又贵又难看

735

735

林生斌与亡妻关联公司均经营异常

70

70

中欧班列“跑”出加速度

203

203

爸爸带娃穿雨衣路边求溅水

49

49

猪价上升周期来了吗?专家发声

605

605